DragGAN(交互的基于点的图像操作)

DragGAN(交互的基于点的图像操作)

基础

StyleGAN2

优点

- 可以进行多点操作

- 可以使handle points 准确的接近 target points

方法(简略版)

- 对handle points 进行监督,使其向target进行移动

- 对handle points 进行追踪,使得他们每走一步都已知他们的位置

方法(详细版)

得到一个图像的图 \(I\)以及他的潜在编码 \(w\), 然后进行优化。

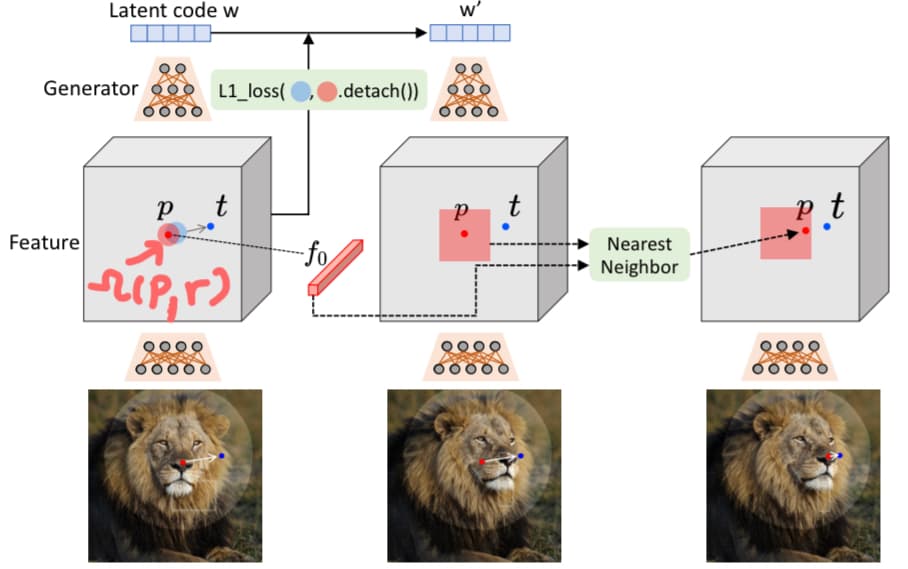

优化分为两步,一个是 motion supervision 和 point tracking 然后将得到新的图像 \(I’\)和新的潜在编码 \(w’\).

Motion Supervision

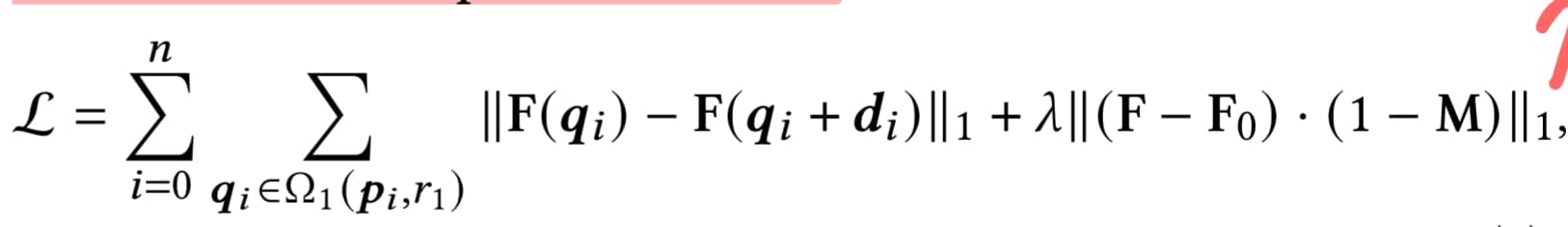

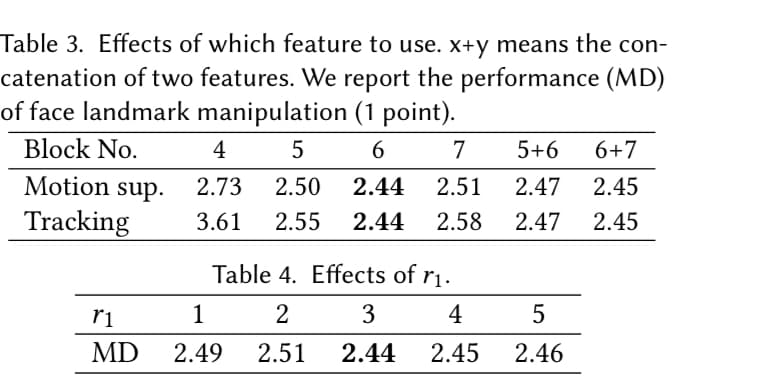

利用生成器中间特征十分具有辨识度的特征进行loss计算。特征图 \(F\)在StyleGAN2的第6个block后是最好的。

移动 \(p_i\) 到 \(t_i\)的步骤是通过计算loss.

这个loss用来优化潜在编码 \(w\), 且只优化前6层

Point Tracking

目标是:更新每个handle points \(p_i\)

方法是:在一个特征patch上进行Nearest Neighbor search

评价指标

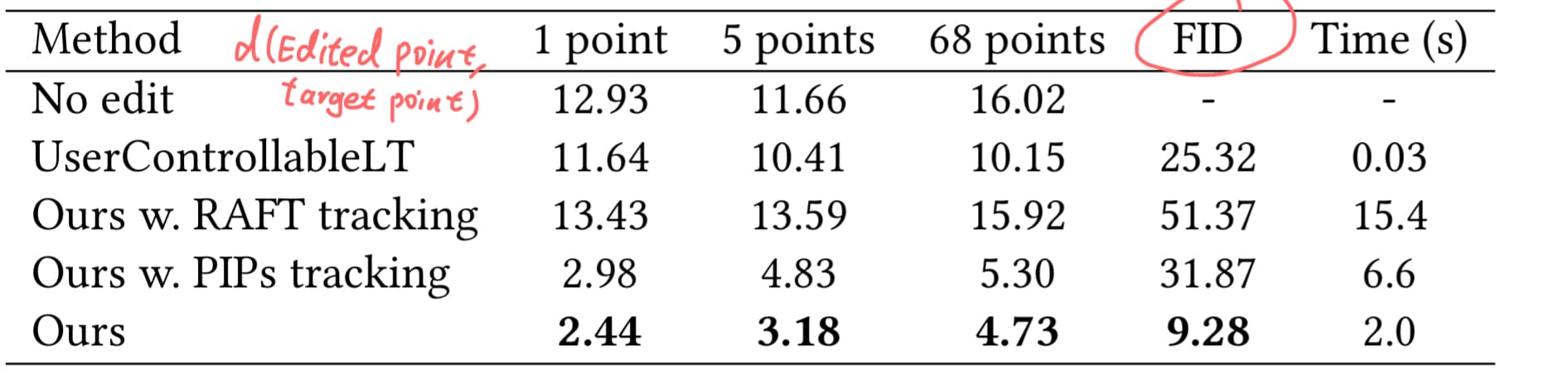

\(d(Edit Point,Target Point)\) 编辑点与目标点的平均距离

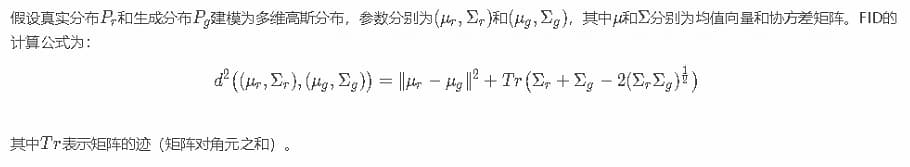

\(FID\) 反应两组图像的相似度。生成图和真实图特征向量间距离。越小越像

时间

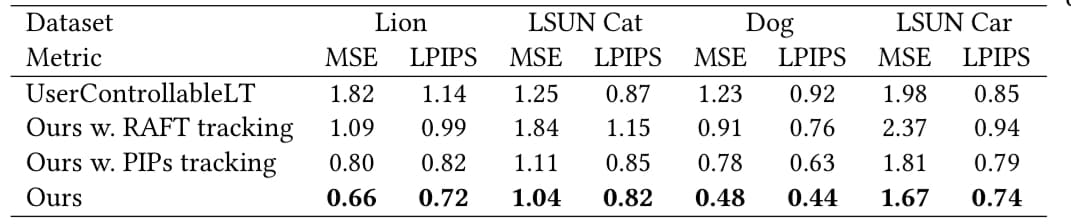

\(MSE\) Mean Square Error 均方误差

\(LPIPS\) Learned Perceptual Image Patch Similarity 学习感知图像快相似度 衡量两张图的差别 越小越像

\(MD\) mean distance平均距离

主要baseline是UserControllableLT

定量评价

Face landmark manipulation

利用off-the-shelf tool的预测作为ground truth. 然后利用DragGAN进行manipulation然后计算得到图片与ground truth做mean distance(MD).MD可作为评价方法移动的好坏。同时计算了FID. 最大优化步骤为300

Paired image reconstruction

利用和UserControllerableLT同样的设置。利用 \(w_1\)和 \(w_2\)生成 \(I_1\)和 \(I_2\)。并选取32个像素作为 \(U\)并与 \(I_1\)作为输入。来重建 \(I2\)。最大优化步骤为100

Ablation Study

研究表明StyleGAN第6块后特征图表现最佳。

讨论

- 遮罩对移动有影响

- Manipulation 具有超出分布的可能。防止这种情况可以增加正则化

- 局限性 编辑质量受训练集的影响